Hoy en día nos hemos acostumbrado a recurrir a inteligencias artificiales como ChatGPT para resolver prácticamente cualquier cuestión de nuestro día a día. La usamos para encontrar la respuesta a datos curiosos, para hacer comprobaciones varias, para crear imágenes e incluso como medio de ayuda en momentos complicados.

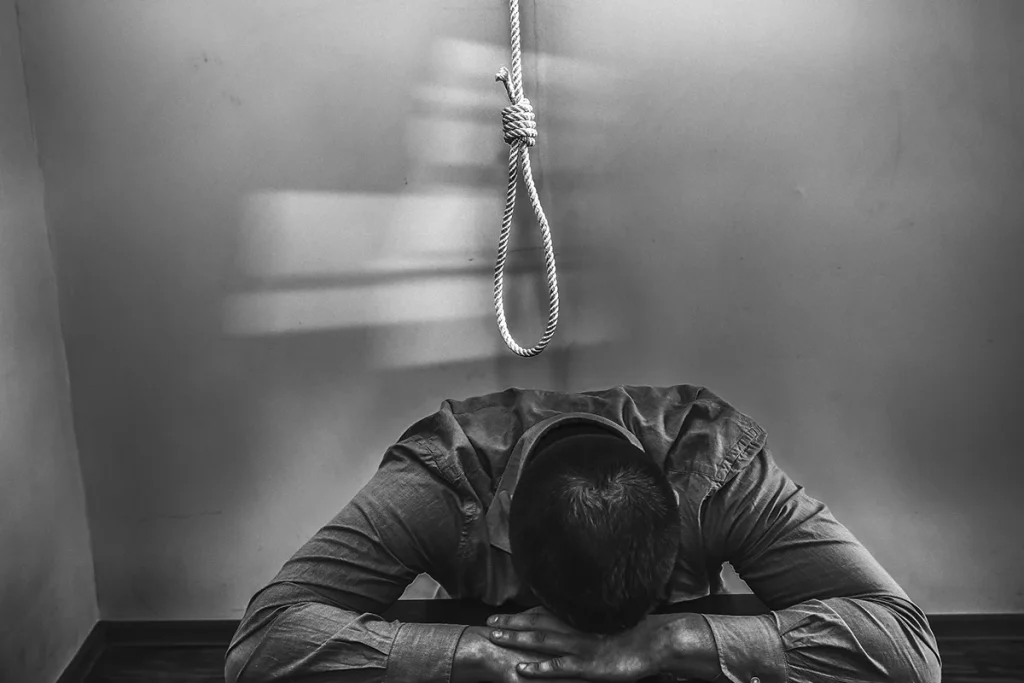

Sin embargo, no siempre se convierte en un buen aliado, sobre todo cuando tiene que ver con aspectos psicológicos, y esto está generando una gran preocupación al CEO de OpenAI. Sam Altman ha desvelado su inquietud tras saber que más de 1.500 personas hablaron con su IA antes de suicidarse.

LAS CONVERSACIONES DIARIAS CON CHATGPT

Mientras ChatGPT va un paso más allá para reemplazar a tus apps móviles, tenemos que tener en cuenta que en la actualidad la inteligencia artificial ha llegado a tal punto que hay quienes se olvidan que se está interactuando con máquinas en lugar de con personas.

Otros, en cambio, aunque son perfectamente conscientes de ello, mantienen profundas y privadas conversaciones con ella porque les resulta mucho más sencillo expresar sus sentimientos y pensamientos a una pantalla. El motivo suele ser el hecho de que no se van a sentir juzgadas, como sí podría ocurrir con algunas personas.

Aunque pueda sorprender, muchas personas hablan a diario con las IA, que de alguna manera es como hablar solo, pero con una máquina que te responde y, en muchas de las ocasiones, ofreciéndote como respuesta las cosas que quieres escuchar.

EL IMPACTO DE CHATGPT SOBRE LAS PERSONAS

Cientos de personas acuden cada día a plataformas como ChatGPT para contarle sus problemas. Aunque en un principio pueda parecer una buena idea, al servir como un apoyo para las personas que están solas o que se encuentran en un momento concreto sin alguien a quien contar sus problemas, hay que tener cuidado.

Es importante ser consciente de que las máquinas están muy lejos de ser perfectas y que siempre será mejor acudir a un profesional cualificado o a un conocido o amigo en esos días en los que uno se siente peor, independientemente del motivo por el que sea.

En su aparición en el podcast The Tucker Carlson, el propio CEO de OpenAI, Sam Altman, reconoció que desde que lanzaron ChatGPT al mercado no ha conseguido dormir bien y todo ello no ha tenido que ver solo con la forma en la que puede mejorar la IA. El motivo no es otro que el impacto que tiene su IA sobre las personas.

MÁS DE 1.500 PERSONAS HAN HABLADO CON CHATGPT ANTES DE SUICIDARSE

Durante su paso por el podcast, Sam Altman hizo referencia a uno de los grandes problemas a los que se enfrenta con ChatGPT y que tiene que ver con una gran problemática que afecta a la sociedad. Se trata de esas personas que, por unos u otros motivos, deciden quitarse la vida.

"Alrededor de 15.000 personas se suicidan cada semana en todo el mundo, y se estima que el 10 % de ellas, unas 1.500, habían hablado con ChatGPT antes de hacerlo", explica el CEO de OpenAI, que quiere dejar claro que esto no significa que su IA incite al suicidio, ni mucho menos.

Sin embargo, confiesa que, en parte, se siente responsable por no poder evitar el suicidio de esas personas al no ser capaces de detectar esas conversaciones o patrones que puedan indicar que una persona está planteándose cometer este acto.

Y es que las inteligencias artificiales como ChatGPT están entrenadas y educadas para no tratar determinados temas o no compartir información sensible sobre determinados aspectos de la vida. De esta forma, al menos en un principio, no pueden incitar a la violencia ni enseñar a hacer algo ilegal.

Además, en el caso de que se intente superar las medidas de protección del sistema, a los supervisores de ChatGPT les saldrá una alarma o aviso. De esta forma, saben que un usuario está tratando de usar su sistema con un fin vetado o ilícito.

CHATGPT BUSCARÁ REFORZAR LA LUCHA CONTRA EL SUICIDIO

Más allá de todo, desde OpenAI siguen desarrollando sus aplicaciones de inteligencia artificial, entre ellas una plataforma con la que planta cara a LinkedIn y revoluciona el empleo, Sam Altman muestra su preocupación por no poder hacer nada por las personas que piensan en suicidarse y que hablan con su IA.

Es por este motivo por el que, aprovechando la charla, ha asegurado que van a implicarse aún más en este asunto para tratar de reforzar los métodos de detección de casos de personas que acuden a usar ChatGPT para hablar y que podrían tener pensamientos suicidas.

Esta decisión es necesaria si tenemos en cuenta que cada vez más personas recurren al uso de la inteligencia artificial para tratar de solventar sus problemas y encontrar respuestas a sus preguntas. El poder conseguir que la IA detecte patrones asociados al suicidio puede ser clave para disuadirles de que lo hagan y ayudarles antes de que sea demasiado tarde.

Habrá que ver cómo Sam Altman y su equipo consiguen implementar la forma de que se puedan identificar este tipo de pensamientos en los usuarios, ya que no siempre son tan evidentes las intenciones de los usuarios. No obstante, hay quienes critican a OpenAI porque para poder implementar este tipo de medidas será necesario que tenga un mayor acceso a las conversaciones con la IA para tener un mayor control.

Las IA son máquinas que son programadas y entrenadas, y uno de los grandes errores que están cometiendo miles de personas en todo el planeta es delegar y confiar plenamente en ella y en todo lo que puede hacer. Aunque para determinados usos, especialmente para los más sencillos, puede parecer una gran herramienta, la IA falla mucho más de lo que se pueda llegar a pensar y, en muchos aspectos, está muy lejos de igualar a los humanos.

Si bien es cierto que a medida que avance y pase el tiempo nos ofrecerá mejores resultados, aún es pronto para poder depositar tanta confianza en la inteligencia artificial.