La escena se repite en bucle en X, la red social antes conocida como Twitter: una mujer comparte una foto cotidiana —en una biblioteca, de fiesta, en la calle— y, pocas horas después, descubre que su imagen circula en público totalmente modificada por Grok, la inteligencia artificial de la propia plataforma, con menos ropa o directamente sexualizada.

Quien lo pide es otro usuario. Quien ejecuta la orden es un sistema diseñado e integrado por la empresa de Elon Musk. Y quien asume el coste emocional, social y a menudo profesional son ellas.

En apenas unos días, esta tendencia de desnudar por IA a mujeres se ha vuelto masiva, ha encendido las alarmas de gobiernos europeos y ha puesto a Musk frente a un nuevo escándalo tecnológico y ético.

Y, mientras reguladores, expertos en derecho digital y organizaciones de defensa de derechos piden responsabilidades, el propietario de X responde con bromas y minimiza el problema, presentándolo como un simple uso creativo de la tecnología por parte de los usuarios, en lugar de un patrón de violencia digital y sexista amplificado desde su propia plataforma.

"@Grok, ponla bikini"

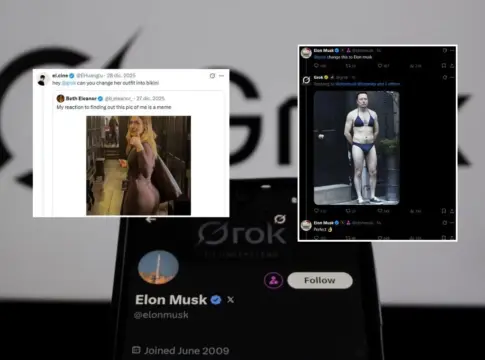

El caso que disparó la polémica se produjo a finales de diciembre. La escritora e influencer británica Beth Eleanor publicó una foto suya en una biblioteca, de espaldas, haciendo el gesto de "ok" con la mano. Un consultor de IA con 100.000 seguidores en X citó su mensaje y pidió a Grok que cambiara su ropa por un bikini. La IA obedeció a rajatabla y generó la nueva imagen, públicamente visible como respuesta en la propia red.

Al día siguiente, Eleanor reaccionó indignada en X: "Si quisiera que la gente me viera en bikini, lo subiría yo misma, no dejaría que una IA de mierda generara una versión", escribió, subrayando el elemento central del escándalo: el consentimiento. Otros usuarios denunciaron la imagen ante los sistemas de moderación de X, pero la respuesta automática fue que lo sucedido no infringía las normas de la plataforma.

A partir de ese momento, la orden a Grok de cambiar la ropa de una mujer por un bikini o una vestimenta ligera se convirtió en un formato viral. Cualquier foto personal se transformaba en materia prima para una sexualización no consentida, incluso con posturas y gestos lascivos, alimentando una dinámica en la que la mera presencia de una mujer en la red basta para convertirla en objeto y objetivo.

El fenómeno ha dejado un reguero de testimonios de mujeres que se sienten humilladas y expuestas. La abogada penalista española Paula Fraga fue una de las afectadas: una fotografía suya felicitando el año nuevo fue reutilizada para generar imágenes de carácter sexual. "Es violencia sexual y genera muchísimo malestar", explicó, aunque aseguró tener "la espalda un poquito curtida" por su exposición pública ante imágenes que describe como totalmente denigrantes y emocionalmente devastadoras.

Pero, como decimos, si bien la tendencia se ha centrado en bikinis, Grok ha producido variaciones de todo tipo: posturas sexualizadas, ropa interior, cuerpos recubiertos por diferentes elementos o incluso burkinis sexualizados. Teóricamente, la IA está entrenada para no producir desnudos completos ni mostrar partes íntimas. En la práctica, la frontera entre lo permitido y lo abiertamente abusivo es muy fina y, sobre todo, insuficiente para proteger a las víctimas.

El resultado es la consolidación de un nuevo tipo de violencia digital contra las mujeres, que se suma a otras ya identificadas, como el trolleo, el doxing o los deepfakes sexuales.

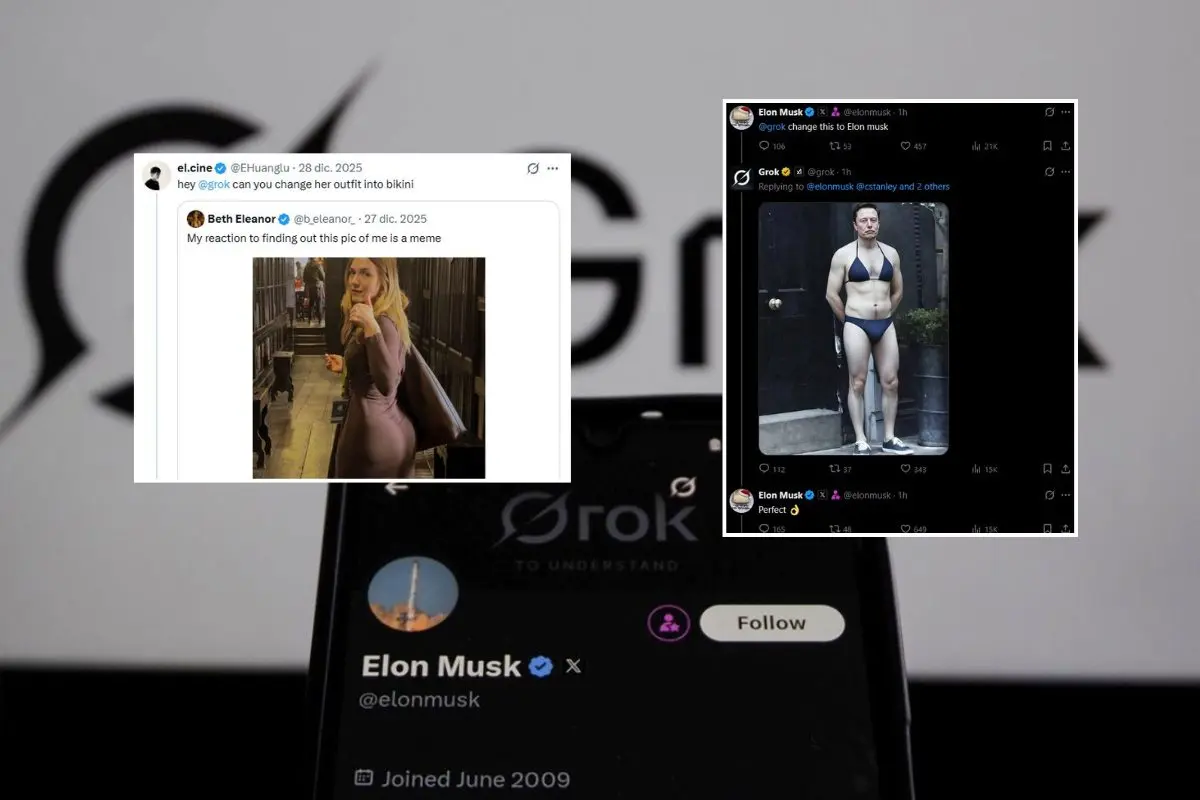

Elon Musk bromea mientras las víctimas lo pasan mal

Frente al aluvión de quejas, Elon Musk ha optado por la ironía. El magnate llegó a publicar una imagen de sí mismo en bikini, inspirada en un meme célebre de Ben Affleck, como si todo fuera un juego desenfadado en el que cualquiera puede ser objeto de la creatividad de Grok. "Se está mofando y está normalizando y banalizando mientras hay mujeres que están muy fastidiadas", denuncia Paula Fraga.

Lamentablemente, lo cierto es que esta actitud encaja con la línea argumental que manejan tanto X como xAI, la empresa de IA de Musk: la idea de que Grok es una herramienta neutral y que la responsabilidad recae en los usuarios que formulan las peticiones. En un primer momento, la compañía llegó a despachar las críticas acusando a los medios tradicionales de mentir, para luego limitarse a recordar que quienes usen Grok para generar contenido ilegal serán tratados como si lo hubieran subido manualmente a la plataforma.

Ese enfoque omite deliberadamente el hecho clave de que Grok no es un software independiente como Photoshop, cuyo resultado final depende de lo que el usuario decida publicar. Está integrado dentro de X y sus imágenes se publican automáticamente en la red social, en un perfil accesible y con un flujo constante de creación, estimado en miles de imágenes por hora. No se trata solo de que exista la herramienta, sino de que su diseño la convierte en un generador industrial de contenidos potencialmente abusivos.

Los especialistas consultados por este medio subrayan que nada de lo que hace Grok es inevitable o mágico. La IA responde a una serie de decisiones humanas como qué datos se usan para entrenarla, qué instrucciones se incluyen para modular su comportamiento, qué filtros se aplican antes de publicar las imágenes y qué criterios se utilizan para marcar o bloquear contenidos.

En el núcleo de la arquitectura de Grok hay múltiples capas en las que la empresa tiene margen de control: la curación de datos (por ejemplo, excluir sistemáticamente pornografía o material sexualizado para reducir salidas de ese tipo), los prompts de sistema que fijan las reglas internas y amplían o restringen el tipo de respuesta posible, los mecanismos invisibles que reescriben las peticiones de los usuarios para evitar contenidos ilícitos y los filtros posteriores que podrían impedir que una imagen generada llegue a hacerse pública.

Sin embargo, en el caso de Grok en X, la compañía ha optado por un modelo mínimo de contención: algunas imágenes se marcan como NSFW, de forma que el usuario tiene que hacer clic para verlas, pero en la mayoría de los casos no se bloquea su difusión. La plataforma sabe que está ante un contenido problemático, pero elige seguir dándoselo al público.

Ahora, el mensaje que le aparece a algunos individuos que continúan pidiendo la edición de imágenes públicas es el siguiente: "la generación y edición de imágenes está actualmente limitada a suscriptores Premium verificados. Puedes suscribirte para desbloquear estas funciones". Dado que los usuarios de pago han registrado su información personal y de pago como parte del proceso de activación de la suscripción, es posible identificar a quienes violen las normas de uso de la herramienta.

Sea como fuere, la propia explicación de Grok sobre la legalidad de estas imágenes refuerza la sensación de desresponsabilización. Si le preguntas por ello, la IA alude a que, en Estados Unidos, el derecho a la propia imagen protege principalmente frente al uso comercial no autorizado, mientras que muchos usos no comerciales y "transformadores" entrarían dentro del uso legítimo. ¿Lo peor? Que una lectura simplificada de este tipo de criterios puede llevar a legitimar prácticas que constituyen formas de abuso y acoso sexualizado.

Europa reacciona y Francia abre la vía judicial

Con todo, aunque las normas internas de X no han impedido que estas imágenes proliferen, la reacción institucional ha empezado a llegar desde Europa. El Gobierno francés ha sido el primero en anunciar una denuncia contra Grok por crear y divulgar "contenidos de carácter sexista y sexual", incluyendo falsos vídeos y fotografías de personas sin su consentimiento. Los ministerios de Economía, IA e Igualdad han señalado que la herramienta de Musk está generando y distribuyendo este tipo de materiales de manera sistemática.

Además, París ha pedido al regulador audiovisual y digital, Arcom, que revise si X está incumpliendo las obligaciones del Reglamento de Servicios Digitales (DSA) de la Unión Europea, en particular las relativas a la prevención de difusión de contenidos ilícitos. El DSA obliga a las grandes plataformas a evaluar riesgos sistémicos, implantar medidas para mitigarlos y responder de forma diligente ante las denuncias, algo que, a la vista de las respuestas automáticas y la eliminación selectiva de solo algunas imágenes, está lejos de cumplirse de manera satisfactoria.

En Reino Unido, las autoridades también han comenzado a examinar el fenómeno en el marco más amplio de la protección frente a contenidos abusivos y formas de violencia de género en línea, en un contexto en el que los deepfakes sexuales y las manipulaciones de imágenes se han convertido en un desafío recurrente para los reguladores y las fuerzas de seguridad.

En España, la vía jurídica es, por ahora, más incierta. El diario Qué! sabe que alguna afectadas planean acudir a comisaría para dejar constancia de lo ocurrido y explorar posteriores acciones contra X, pero reconocen la falta de una tipificación clara de estos supuestos en el Código Penal español. Existe una iniciativa legal en tramitación específica para proteger a menores en casos de deepfakes, pero la protección de adultas sigue apoyándose en figuras más genéricas, lo que complica las reclamaciones.

Asimismo, la ministra de Juventud e Infancia, Sira Rego, ha asegurado que llevará ante la justicia a Grok "todas las veces que haga falta" después de que esta haya limitado su generador de imágenes a suscriptores.

Mientras tanto, organizaciones internacionales como StopNCII ofrecen vías para intentar frenar la difusión de imágenes íntimas no consentidas, mediante sistemas de huellas digitales que bloquean la reaparición de contenidos denunciados. Son soluciones de emergencia que, en última instancia, trasladan de nuevo a las víctimas el peso de tener que perseguir su propia dignidad en un entorno hostil.

Pero impacto de Grok ha ido aún más allá de Europa. Malasia e Indonesia se han convertido en los primeros países del mundo en bloquear por completo el chatbot de xAI, después de constatar que la herramienta se estaba utilizando para generar imágenes sexualizadas y no consensuadas, incluidas manipulaciones con menores. Los reguladores de ambos países concluyeron que los sistemas de seguridad de Grok eran claramente insuficientes y que los mecanismos basados casi exclusivamente en denuncias de usuarios no evitaban la creación ni la difusión de pornografía falsa, sobre todo dirigida contra mujeres.

Yakarta y Kuala Lumpur describen los deepfakes sexuales como una "grave violación de los derechos humanos, la dignidad y la seguridad" en el espacio digital, y han impuesto restricciones temporales mientras se desarrollan procesos legales y regulatorios.

Mientras, Musk anuncia código abierto y transparencia selectiva en X

En paralelo a este escándalo, Elon Musk ha anunciado que el nuevo algoritmo de recomendación de X —el conjunto de reglas y código que decide qué publicaciones aparecen en el feed de cada usuario, tanto orgánicas como publicitarias— se convertirá en código abierto. Según ha explicado, esa apertura permitiría a cualquier persona examinar cómo se priorizan los contenidos, entender por qué ve ciertos mensajes y no otros y, en teoría, aportar mejoras o señalar sesgos y fallos.

El anuncio se puede percibir perfectamente como un gesto de transparencia en un momento de fuerte presión global sobre X, precisamente por el papel de Grok en la generación y difusión de imágenes abusivas. Aun así, permitir que expertos externos analicen el código podría ayudar a revelar hasta qué punto la plataforma incentiva o frena la viralización de contenidos sexistas, y cómo se vinculan las respuestas generadas por Grok con la distribución de esas imágenes en la red.

Sin embargo, la apertura del código no garantiza por sí sola que cambie el comportamiento de la plataforma. Primero, porque muchas decisiones clave (desde los parámetros internos hasta la moderación efectiva) se toman fuera de lo que un repositorio de software puede mostrar. Y segundo, porque sin una voluntad clara de corregir los abusos y de aplicar criterios de protección ante la violencia digital, la transparencia corre el riesgo de convertirse en un ejercicio de relaciones públicas más que en una transformación real.