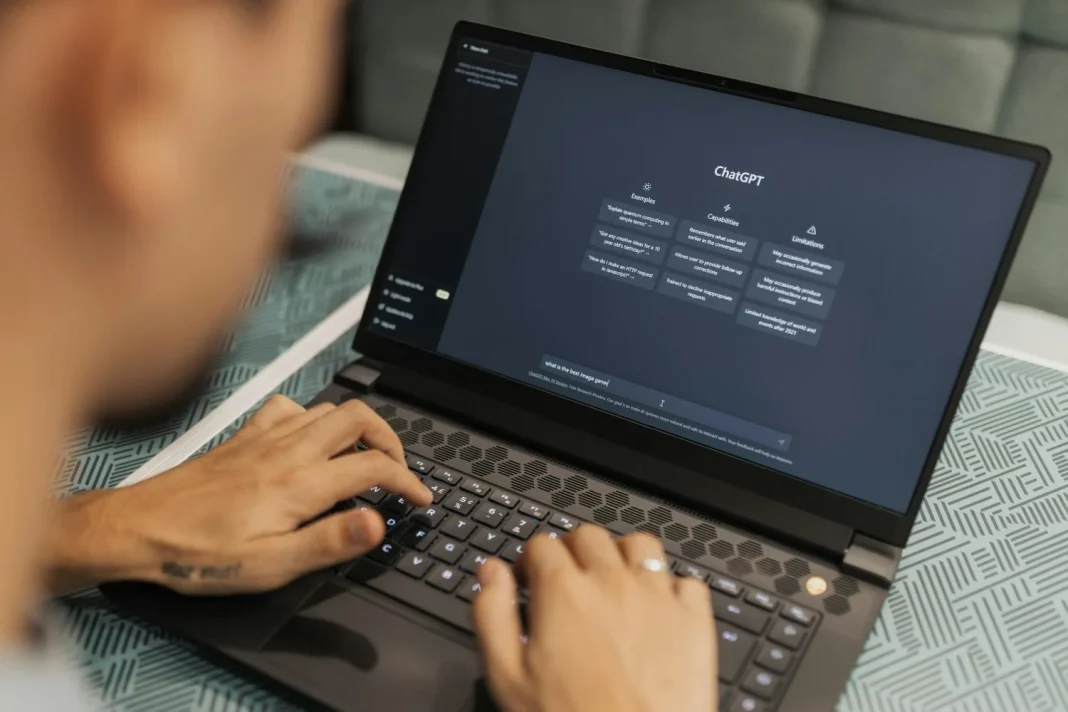

El debate sobre el papel de la inteligencia artificial en la atención psicológica se ha intensificado en los últimos tiempos. Cada vez más personas recurren a herramientas como ChatGPT en busca de orientación emocional, espiritual, astral, compañía o incluso respuestas sobre diagnósticos. Sin embargo, profesionales de la salud mental advierten que el uso de estos modelos en aspectos terapéuticos no está exento de riesgos.

Lo que para muchísimas personas representa una alternativa accesible y de bajo costo, para otros significa una amenaza en términos de seguridad, privacidad y ética clínica. La pregunta que domina entre los especialistas es: ¿ChatGPT es una innovación en la salud mental o un peligro para quienes lo usan como sustituto de un terapeuta?

2Riesgos clínicos y éticos del uso de ChatGPT

El principal peligro de este uso en específico, según los especialistas, es que algunos usuarios interpreten las respuestas de ChatGPT como diagnósticos médicos reales. La herramienta, aunque puede relacionar síntomas descritos con categorías clínicas, no está capacitada para realizar evaluaciones completas ni dar diagnósticos médicos o mentales.

Joshua Curtiss, profesor adjunto de psicología aplicada, alerta sobre esta práctica: «Parece una pendiente resbaladiza. Si le digo a ChatGPT que tengo cinco de los nueve síntomas de depresión, dirá que parece que tengo depresión y ahí se queda. Lo que el médico haría es una evaluación clínica estructurada con ejemplos y validaciones sobre el impacto real en la vida del paciente».

Este enfoque puede llevar a los usuarios a tener conclusiones equivocadas, reforzar malestares o agravar cuadros de ansiedad y depresión. Hoffman advierte que: «ChatGPT no es un terapeuta capacitado. No cumple con las obligaciones legales y éticas de los proveedores de servicios de salud mental. Me preocupa la seguridad y el bienestar de las personas que recurren a ChatGPT como su único proveedor».

Los expertos afirman que en casos extremos se han documentado suicidios y hospitalizaciones vinculadas a la llamada «psicosis de IA», un fenómeno en el que la interacción obsesiva con chatbots genera pensamientos delirantes, o lo que es lo mismo, alteración de la realidad.

Otro aspecto crítico aunado a ChatGPT es la privacidad. Mientras los profesionales están sujetos a normativas como la HIPAA en Estados Unidos, los chatbots no ofrecen las mismas garantías. El propio Sam Altman, director ejecutivo de OpenAI, reconoció que no existe confidencialidad absoluta en las conversaciones con ChatGPT.